PHOTO

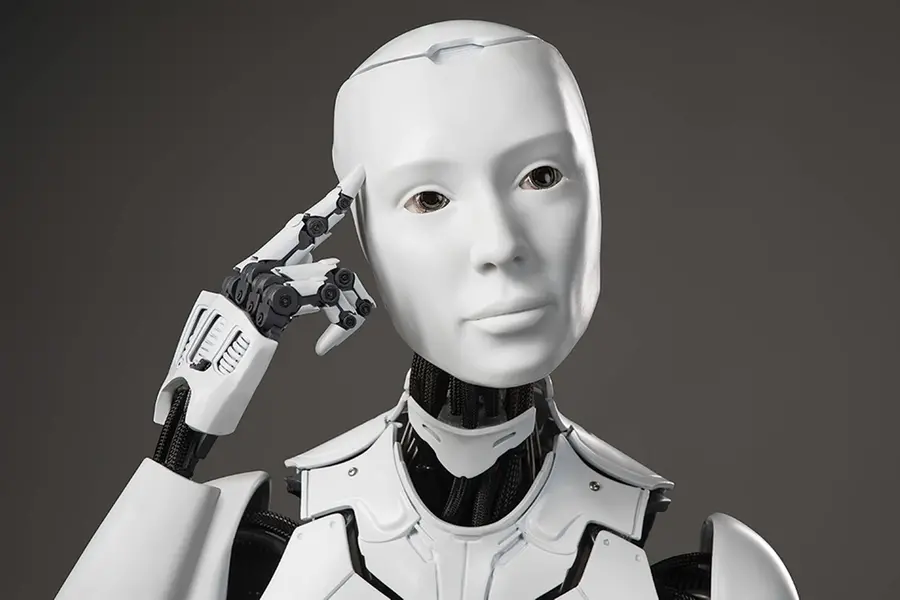

1. Non siamo più soli

Ogni codice etico e giuridico sviluppato da qualsiasi civiltà ha sempre avuto quale suo referente l’Uomo. L’Uomo come individuo e l’Uomo come appartenente a formazioni sociali: membro di una famiglia, cittadino, lavoratore, consumatore. La novità è che oggi l’Uomo non è più il solo a potersi dire intelligente e ad avere capacità decisionale e di azione autonoma. Non abbiamo neppure dovuto attendere l’arrivo di forme d’intelligenza aliena sulla Terra perché ciò accadesse. Ed infatti i robot, una volta soltanto sussidio industriale, sono usciti dalle fabbriche ed hanno iniziato ad abitare altri luoghi: l’interno del corpo umano, il mondo sottomarino, lo spazio. È l’era in cui i robot vivono in mezzo a noi, ci aiutano, ci connettono, a volte ci sostituiscono ed interagendo con noi, soprattutto, ci cambiano e, con noi, trasformano la società tutta (M. C. Carrozza, I robot e noi, Il Mulino, 2017).

2. Se la macchina pensa

Seguire l’evoluzione della robotica è, dunque, imprescindibile per comprendere la sfida culturale, etica, giuridica e politica che la quarta rivoluzione industriale si porta con sé. Significa, paradossalmente, fare un viaggio nel futuro dell’umanità, tentandone di capire l’essenza, guardando appunto il non- umano, eppure essere intelligente. Si deve allora ridefinire il concetto di “intelligenza”. Operazione già di per sé per nulla scontata potendo rientrare in tale concetto accezioni diverse: capacità di ragionamento logico, comprensione, pianificazione, autoconsapevolezza, creatività, risoluzione di problemi, apprendimento, etc. Conviene assumere una definizione ampia di intelligenza, come suggerisce Max Tegmark (Vita 3.0. Esseri umani nell’era dell’intelligenza artificiale, Raffaello Cortina Editore, 2018): l’intelligenza è la «capacità di realizzare fini complessi», o anche «abilità di acquisire e applicare conoscenze e competenze».

Così posto il tema, la domanda che ne segue è: per parlare di un’entità intelligente è sufficiente la capacità di computazione, cioè quella di produrre in automatismo calcoli, od occorre anche un certo grado di comprensione? In altri termini, per dirsi intelligente, la macchina dovrà soltanto restituire una risposta corretta dopo avere elaborato le informazioni acquisite, o piuttosto anche dimostrare di aver compreso il quesito e di rispondere in un certo modo, in ragione di elementi non soltanto memorizzati, ma anche condivisi e fatti propri?

3. Si apre la delicata questione della differenza fra memoria e apprendimento

Il c. d. deep learning, basato sulla riproduzione di vere e proprie reti neurali artificiali per l’elaborazione di un apprendimento automatico profondo, diventa operazione complessa, vera e propria emulazione cerebrale, non semplicemente simulazione dell’umano come ha spiegato Jean Baudrillard (Cyberfilosofia, Mimesis, 2010). La macchina non si accontenta più di riprodurre un percorso logico, ma vuole incarnare un nostro clone e seguirci, forse superarci, oltre le abilità razionali, nei campi che abbiamo sempre ritenuto essere una nostra esclusiva e inattaccabile prerogativa: la speculazione filosofica, l’arte, il gusto, il sesso, le emozioni, addirittura i sentimenti. La simulazione neurale rimette in discussione tutto. Travolge secoli di metodo scientifico, principio di causalità e logica aristotelica.

L’empirismo potente e veloce dei Big Data non è eguagliabile dalla natura umana. Ambisce a proporre un’idea di Verità che, in quanto matematica, diventa pericolosamente definitiva ed indiscutibile, frutto di sistemi predittivi calibrati su simulazioni algoritmiche. Dominique Cardon ha scritto: «Gli algoritmi ci hanno liberati dai viaggi di gruppo, dei punti di vista obbligati e dalle soste obbligatorie davanti ai panorami da souvenir. Essi nascono da un desiderio di autonomia e libertà. Tuttavia contribuiscono anche ad assoggettare l’internauta a quella strada calcolata, efficace, automatica, che si adatta ai nostri desideri regolandosi, in segreto, sul traffico altrui». Ma, aggiunge anche, «Insieme alla carta, ci siamo persi il paesaggio» (Che cosa sognano gli algoritmi, Mondadori, 2016).

4. Il punto di non ritorno: l'essere artificiale

Siamo, dunque, avviati verso quel punto critico oltre il quale lo sviluppo tecnologico accelera oltre la stessa capacità di comprensione e di previsione degli esseri umani? Certo, la prospettiva verso cui stiamo marciando pare inarrestabile ed è esattamente questa: una super- intelligenza artificiale nella quale la macchina acquisisce una consapevolezza di sé. Diventa essa stessa “persona artificiale”, antesignana di una “oltre- umanità”, che potrebbe arrivare un giorno a considerare l’umano quasi “troppo umano”… Non è uno scenario per gli amanti dei film di fantascienza. È realtà. Si realizza in embrione ogni giorno, senza una nostra piena consapevolezza. Accettiamo con benevolenza l’affiancamento della macchina alla nostra quotidianità, che ci semplifica la vita, anticipando ogni nostra esigenza o desiderio. Il prezzo da pagare è la dipendenza tecnologica. Le macchine si impossessano di attività che col passare degli anni non saremo più in grado - il che peraltro avviene già anche adesso - di svolgere in autonomia.

La questione allora da risolvere prioritariamente è: cosa vogliamo veramente dalle intelligenze artificiali? Quanto la nostra dipendenza tecnologica può evolversi in una dipendenza psicologica? Essendoci abituati a tradurre corpi, parole e immagini in dati abbiamo dato agli algoritmi il codice ideale per interpretarci, leggerci dentro, mentre noi, ingenuamente, crediamo di poter serbare ancora segreti chiusi nella nostra anima. Cosa rimane della privacy se non siamo più soli nemmeno nel nostro io più profondo, dove sorgono desideri e bisogni a livello inconscio ed istintuale, ma intercettabili da un algoritmo prima ancora di vedere la luce della volontà strutturata?In questa dimensione la sfida per la protezione dei dati, se presa sul serio, diventa davvero essenziale, unico e ultimo baluardo a tutela dell’identità, della persona, dell’umanità/ natura umana.

5. La leggibilità degli algoritmi

Gli algoritmi ci conoscono, ci mettono a nudo. Ma esiste una qualche forma di reciprocità? Si discute, in proposito, di un diritto alla leggibilità dell’algoritmo. La formula usata è Explainable Artificial Intelligence, ovvero come riuscire a garantire l’esplicabilità degli algoritmi, conditio sine qua non per creare e mantenere la fiducia degli utenti nei sistemi di intelligenza artificiale. Il tema è stato affrontato a più riprese. Nel documento sugli “Orientamenti etici per un’IA affidabile” elaborato nell’aprile 2019 dal gruppo di esperti istituito dalla Commissione europea si legge che l’esplicabilità «implica che i processi devono essere trasparenti, le capacità e lo scopo dei sistemi di IA devono essere comunicati apertamente e le decisioni, per quanto possibile, devono poter essere spiegate a coloro che ne sono direttamente o indirettamente interessati. Senza tali informazioni, una decisione non può essere debitamente impugnata».

Sembrano affermazioni incoraggianti. Purtroppo si è costretti subito dopo a riconoscere che non sempre è possibile spiegare perché un modello ha generato un particolare risultato o decisione. Ciò in quanto, per la gran parte gli algoritmi, sono da considerarsi sistemi imperscrutabili, una sorta di “black box” per usare la definizione di Frank Pasquale ( The Black Box society. The Secret Algorithms Money and Information, Harvard University Press, 2016). Le scatole nere osservano le caratteristiche degli utenti, profilano, incasellano, giudicano, suggeriscono le decisioni da assumere. Il tutto, però, senza spiegare come arrivano a quella determinata conclusione.

La normativa europea sulla protezione dei dati personali ( artt. 13- 14 Reg. UE 2016/ 679) si è fatta carico del problema ed ha introdotto il principio generale di conoscibilità, per cui ognuno ha diritto di conoscere l’esistenza di processi decisionali automatizzati che lo riguardino. Tuttavia la mera conoscenza dell’esistenza di un algoritmo non produce in sé effetti di rilievo se non si è in grado di decifrarne la logica che ne sta alla base. Per questa ragione il principio di conoscibilità si integra con quello di comprensibilità, ovvero la possibilità di ricevere «informazioni significative sulla logica utilizzata». Ma la conoscibilità- comprensibilità presuppone che gli algoritmi – soprattutto quelli predittivi – abbiano una logica, ovvero che vi sia una sequenza argomentativa ripercorribile e verificabile. Il problema – come si è detto - è che gran parte degli algoritmi di nuova generazione non si limitano a dedurre in maniera deterministica conseguenze da assiomi prefissati dal programmatore, ma, in virtù di sistemi automatici di apprendimento, producono essi stessi criteri che in molti casi non sono comprensibili neppure agli stessi programmatori (A. Simoncini, L’algoritmo incostituzionale: intelligenza artificiale e il futuro delle libertà, in BioLaw Journal, 1/ 2019). Dunque la reciprocità è di fatto assai difficile, oltre alla circostanza che si porta con sé potenziali violazioni di altri diritti meritevoli di tutela giuridica, ad esempio quello alla proprietà intellettuale/ industriale.

6. Etica e diritto senza umanità?

L’inquadramento giuridico delle intelligenze artificiali chiama in causa il principio di responsabilità imprescindibilmente connesso con i limiti e la ragionevolezza in tutto e per tutto umani. Chi dovrebbe essere chiamato a rispondere giuridicamente delle decisioni ed azioni di un’intelligenza artificiale, come ad esempio di un’autovettura autonoma, di un robot- chirurgo, o di un drone armato? Il tema della responsabilità giuridica nel caso di un’intelligenza artificiale che apprende autonomamente è enorme e ancora tutto da affrontare.

E ancora. La persona artificiale è titolare di un’autonoma capacità giuridica? Dopo i diritti degli animali e delle piante, si potranno ipotizzare i diritti delle macchine intelligenti? Un orario minimo di lavoro, il diritto ad un equo processo, il diritto alla libera espressione, il diritto di amare e, infine, anche il diritto alla vita? Ecco, questo davvero no. Perché se, come dicevamo all’inizio, non siamo più i soli esseri intelligenti sul pianeta Terra, siamo certamente i soli esseri viventi intelligenti. E nella consapevolezza della nostra umana precarietà, fragilità, fallacia e temporaneità, siamo i soli in grado di sviluppare quel “sesto senso” che nessuna intelligenza artificiale potrà mai non solo riprodurre o simulare, ma neppure concepire. E dal quale scaturisce proprio il principio responsabilità nelle sue connotazioni sia etiche, che giuridiche: la coscienza.

Nella corsa di macchine sempre meglio programmate per il raggiungimento degli obiettivi secondo la logica della massima efficienza non sono contemplabili errori, intoppi, variazioni. Ed è proprio in ciò che sta il nodo. La prospettiva va, dunque, rovesciata. Dobbiamo rivendicare un diritto a sbagliare, consapevoli della nostra fisiologica fallibilità. Diversamente, il rischio è di trovarsi prede di un totalitarismo dell’efficienza, sostenibile, forse, da un punto di vista economico ed ecologico, ma non umano. Anzi disumano. Un’efficienza che potrebbe arrivare a prevedere addirittura scenari paradossali come l’auto- distruzione, ove calcolata in termini di beneficio collettivo.

Inquietanti i molti interrogativi che si pongono per il destino delle nostre libertà e della nostra democrazia. Ecco perché diventa davvero cruciale, nel metodo, ancora prima che nel merito, dare avvio ad una nuova fase di costituzionalizzazione in “proiezione moderna”. Che abbia lo scopo di «orientare la progettazione, lo sviluppo e l’utilizzazione delle soluzioni di intelligenza artificiale in una direzione eticamente e giuridicamente sostenibile» ( come hanno ben scritto A. Longo, G. Scorza, Intelligenza artificiale. L’impatto sulle nostre vite, diritti e libertà, Mondadori, 2020). E’ un imperativo.